Deep Learning in der Black BoxUnderstanding Digital Capitalism III | Teil 4

8.1.2018 • Gesellschaft – Text: Timo Daum, Illustration: Susann Massute

KI ist heute schon weit mehr der Schenkelklopfer, mit denen die smarten Lautsprecher gut Wetter machen. Die Systeme entscheiden über Kreditvergabe, helfen bei juristischen Entscheidungen und sortieren Bewerberinnen und Bewerber aus. Wie das geht, wissen nur die Hüter der Algorithmen. Auf der Suche nach Antworten und der Transparenz verpflichtet wagt Timo Daum in der vierten Folge von »Understanding Digital Capitalism« daher das Unmögliche: ein Unboxing der Künstlichen Intelligenz. Viel zu sehen gibt es da allerdings nicht. Und genau das ist das Problem: Wir leben in einer Black Box Society. Kafka wusste das schon 1922. Go, figure.

Was bisher geschah:

In der vorherigen Folge ging es darum, was genau genommen Lernen eigentlich ist. Der KI-Pionier Marvin Minski sprach in diesem Zusammenhang von einem typischen suitcase word, einem Begriff also, der sehr weit gefasst, dehnbar wie ein Kaugummi ist und wie so vieles rund um das Thema Künstliche Intelligenz unscharf, subjektiv und irreführend zu sein scheint. Maschinelles Lernen von neuronalen Netzen unterscheidet sich grundlegend vom menschlichen intuitiven Lernen. Es benötigt eine große Menge an Daten, um daraus Muster zu erkennen. Das Standardmodell maschinellen Lernens mit seinen mehreren Schichten führt zu einem eigentümlichen Phänomen: Die Software wird zur Black Box.

Geheimnisvolles Lernen

Wenn wir als Kinder unsere erste Sprache, die Muttersprache, lernen, dann sprechen wir nach, imitieren, sammeln, variieren, probieren aus, kurz: Wir lernen intuitiv. Bald beherrschen wir unsere Muttersprache wie im Schlaf, lange bevor wir mit Konzepten wie Vokabeln, Grammatik oder Satzbau überhaupt in Berührung kommen. Wir beherrschen sie, ohne explizit ihre Regeln zu kennen, ohne zum Beispiel sagen zu können, was eine Partizipialkonstruktion ist. Ganz anders verläuft dann in der Regel das Erlernen aller weiteren Sprachen, der Fremdsprachen: Wir lernen Vokabeln und Regeln und prozessieren Input und Output, ganz wie eine deterministische Symbolverarbeitungsmaschine das auch täte, also wie Software, die ein Programm in formal-logischer Sprache abarbeitet. Das Lernen ist mühsam und unsere Beherrschung der Sprache reicht nie an die Muttersprache heran.

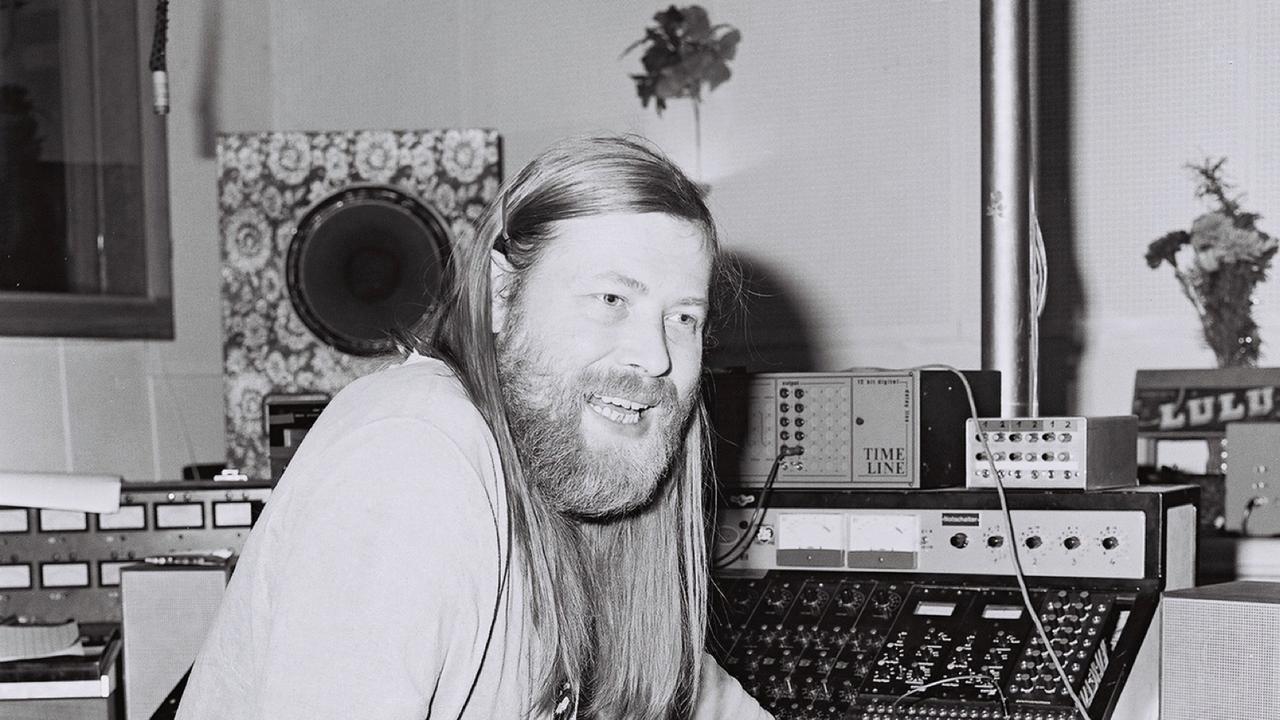

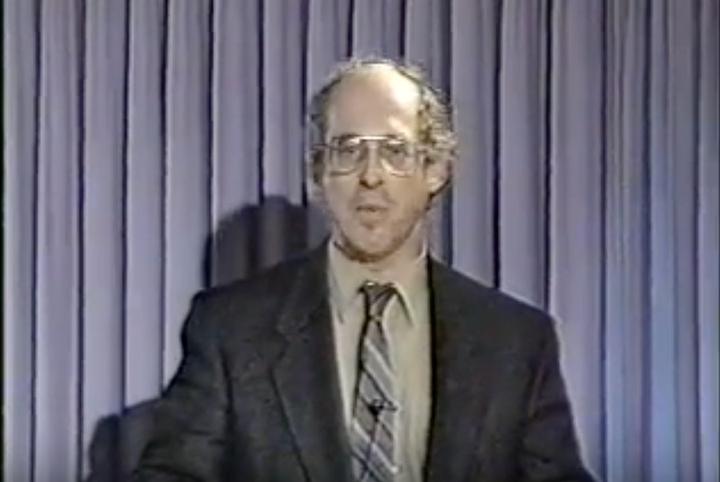

Stephen Krashen, ca. 1980. Quelle: YouTube

Diese Unterscheidung geht auf den Linguisten Stephen Krashen zurück, der mit seiner Theorie des Zweitspracherwerbs seit den 1970er-Jahren einen großen Einfluss erlangte. Krashen differenziert darin prinzipiell zwischen dem bewussten grammatikalischen Prozess des Lernens (learning) und der Aneignung einer Sprache (acquisition) durch Kinder, die ihre erste Sprache lernen. Es handelt sich um grundsätzlich verschiedene Lernprozesse, die im Übrigen in unterschiedlichen Hirnregionen stattfinden. Schlaganfallpatienten verlieren oft die Fähigkeit zu sprechen, wenn bestimmte Bereiche geschädigt sind. Dabei kommt es durchaus vor, dass die Fremdsprachenkenntnisse nicht beeinträchtigt sind, da diese woanders gespeichert sind. Ein Grund mehr, mindestens eine Fremdsprache zu lernen, ist diese doch unter Umständen für diese Patienten die einzig verbleibende Kommunikationsform.

Schon in den Anfangszeiten der KI gab es Überlegungen, Computersystemen Akquisitions-Lernen beizubringen statt auf die Logik von Algorithmen zu setzen: Das nennt man dann deep learning. Dazu wird das menschliche Gehirn in neuronalen Netzen nachgebildet, in denen Stimuli Muster neuronaler Aktivität erzeugen. Diese wiederum erzeugen weitere Muster, die letztlich motorische Reaktionen hervorrufen. Das gesamte Wissen des Systems beruht auf der Art und Weise, wie ein Aktivitätsmuster zu einem anderen führt. Dieses Verfahren ist geeignet für Probleme, die nicht oder nur schwer formal-logisch beschreibbar sind, zum Beispiel für das Erzählen von Witzen. Hier ist es vielversprechender, ein System mit vielen Witzen zu füttern, worauf dieses dann auf Grund von Mustern versucht, neue zu generieren.

Sunspring: Wenn KI Science Fiction schreibt

Beispiele für tiefes Lernen gibt es viele. Ein besonders reizvolles ist Benjamin, eine künstliche Intelligenz, die 2016 ein Science-Fiction-Drehbuch geschrieben hat. Es handelt sich dabei um ein neuronales Netzwerk, das mit über 150 Sci-Fi-Filmskripten gefüttert wurde, unter anderem mit Klassikern wie 2001: Eine Odyssee im Weltraum, 12 Monkeys, Alien, Dune – Der Wüstenplanet, Das fünfte Element, Matrix etc. Die Schöpfer der Software, der Filmemacher Oscar Sharp und sein Technik-Mitarbeiter Ross Goodwin, hatten das System zunächst Jetson genannt, bis es angeblich selbst auf einer Namensänderung bestand. Das Team nahm sich vor, binnen 48 Stunden das Drehbuch umzusetzen, für die Realisierung konnten sie Thomas Middleditch gewinnen, den Hauptdarsteller der HBO-Serie Silicon Valley.

Thomas Middleditch in Sunspring

Das Ergebnis ist Sunspring, ein überraschendes und seltsames futuristisches Psychodrama. Der neunminütige Kurzfilm ist wahrlich kein Meisterstück, es gibt schräge Momente und schwer verständliche Dialoge. Aber es reichte allemal, um zunächst beim Londoner Science Fiction Festival für standing ovations und später auch weltweit für Aufsehen zu sorgen. Benjamin hat auch schon einen Folgeauftrag: Randle is benign ist der Arbeitstitel des Projekts.

KI-Systeme entscheiden heute bereits über Kreditvergabe und helfen bei juristischen Entscheidungen. Das Problem: Nur das Ergebnis liegt in lesbarer Form vor – sein Zustandekommen ist nicht nachvollziehbar.

Neuronale Netze als Black Box

Beim maschinellen Lernen analysiert ein Programm eine große Menge an Daten, versucht Strukturen zu erkennen und Modelle zu generieren, aus denen dann Schlussfolgerungen gezogen werden können. Es wird dabei immer schwerer nachzuvollziehen, wie die Ergebnisse zustande kommen. Sprach- oder Bilderkennung, das Fahrverhalten eines autonomen Systems oder die Qualität natürlicher Sprachausgabe lassen sich noch vergleichsweise einfach auf Richtigkeit und Konsistenz überprüfen. Auch wie gut ein Hautkrebs erkannt, ein Satz übersetzt oder ein Auto gelenkt wird, lässt sich nachträglich evaluieren. Wie sieht die Sache hingegen aus, wenn es um Kreditempfehlungen, Bewährungsentscheidungen oder abgelehnte Asylanträge geht? KI-Systeme entscheiden heute bereits über Kreditvergabe, helfen bei juristischen Entscheidungen und sortieren Bewerberinnen und Bewerber aus. In solchen Fällen wird es zum Problem, dass nur das Ergebnis in lesbarer Form vorliegt, nicht jedoch das Zustandekommen des Ergebnisses überprüfbar, nachvollziehbar und korrigierbar ist.

Kafkas Schloss ist die literarische Verarbeitung der modernen Gesellschaft, die dem ahnungslosen Einzelnen als Black Box gegenübertritt.

Immer öfter entsteht auf diese Weise eine Black Box, die nicht nur für die Öffentlichkeit, sondern selbst für das technische Personal nicht mehr nachvollziehbare Entscheidungen trifft. Der Begriff Black Box kann zunächst eine Apparatur bezeichnen, die etwas aufzeichnet bzw. ein Protokoll anlegt – etwa in einem Flugzeug. Gleichzeitig beschreibt er eine geschlossene, undurchsichtige Kiste, deren innere Konstruktion unserem Zugriff entzogen ist und deren Mechanismen unbekannt sind. Auch lässt sich die Metapher auf Institutionen oder Systeme übertragen, die ihre Ergebnisse in nicht nachvollziehbarer Weise generieren: Kafkas Schloss ist eine literarische Verarbeitung der modernen Gesellschaft, die dem ahnungslosen Einzelnen als Black Box gegenübertritt. Wie lässt sich aus solcher Intransparenz resultierendes Unrecht, wie etwa Diskriminierung durch Algorithmen, vermeiden? Wird ein solches System etwa mit Fotos von Menschen gefüttert, die überwiegend weiß sind, dürfte es kaum verwundern, wenn das Foto einer schwarzen Person als nicht-menschlich identifiziert wird. Es lässt sich unschwer erahnen, was die Lösung sein könnte: noch mehr Algorithmen. Ein Forscherinnenteam mit Google-Beteiligung hat ein Programm geschrieben, das in der Lage sein soll, in Algorithmen eingebaute Diskriminierung nach Gender oder Herkunft zu detektieren – Solutionism at its best.

Black Box Society

Frank Pasquale, Jura-Professor an der University of Maryland und einer der führenden Forscher auf dem Feld der Algorithmic Accountability, hat mit seinem Buch „Black Box Society“ eine Debatte um die Rechenschaftspflicht von Algorithmen angestoßen. Algorithmen sind geheim – in offensichtlichem Gegensatz zum Credo der digitalen Welt, dass wir freigiebig mit unseren Daten umgehen sollen. Die Art und Weise, wie mit diesen auf den Plattformen verfahren wird, welche Algorithmen hier am Werk sind, welche Ziele hier zugrunde gelegt sind, ist Betriebsgeheimnis. In Deutschland hat etwa die Initiative Algorithm Watch diese Gedanken aufgenommen, Forderungen nach einem Algorithmen-TÜV sind laut geworden. Das widerspricht offensichtlich den Interessen der Firmen, die sie einsetzen. Andererseits ist zum Beispiel der Suchalgorithmus von Google im Wesentlichen bekannt, selbst die komplette Veröffentlichung würde das Unternehmen nicht unbedingt aus der Ruhe bringen, hat es doch seine Monopolstellung eher den angesammelten Daten als der konkreten Ausgestaltung des Algorithmus zu verdanken.

Die Ziele und Werte, die in Algorithmen implementiert werden, stellen keineswegs rein technische Fragen, sondern werden zum herausragenden Feld gesellschaftlicher Auseinandersetzung.

Doch nur wenn wir Zugang zu den zugrundeliegenden Modellen haben, können wir diese Entscheidungen nachvollziehen, kritisieren und korrigieren. Aber Banken, Militär, Arbeitgeber und andere Anwender lassen sich ungern in die Karten schauen bzw. ziehen sich auf die Position zurück, dass sie selbst nicht genau wüssten, wie die Entscheidungen zustande gekommen seien, es aber schon seine Richtigkeit habe. Die Ziele und Werte, die in Algorithmen implementiert werden, stellen keineswegs rein technische Fragen, sondern werden zum herausragenden Feld gesellschaftlicher Auseinandersetzung. Ein Beispiel: Ubers Algorithmen berechnen die Fahrpreise dynamisch und versuchen höchstmögliche Preise zu erzielen, ohne dabei Kunden abzuschrecken, also den Profit der Plattform zu maximieren. Demgegenüber wäre es geradezu ein Leichtes, bestimmte Tarifstrukturen vorzugeben oder anti-diskriminatorische Standards zu implementieren, wie das beim Taxi-Gewerbe auch geschieht, also Transparenz über Auftragsvergabe zu erreichen – und das letztlich sogar neutraler, als das etwa bei Telefon-Vermittlungszentralen möglich wäre, bei denen der menschliche Faktor eine große Rolle spielt.

Ne touche pas mon algorithme

Die Geheimhaltung von proprietärer Information etwa über Patente gehört schon immer zum Kapitalismus. Derzeit nehmen allerdings Black Boxes überhand, Konzerne lassen sich immer weniger in die Karten, sprich: in die Algorithmen schauen, verschanzen sich hinter Geschäftsgeheimnissen, Verschwiegenheitserklärungen, Lizenzvereinbarungen und Nutzungsregeln. Diese Geheimniskrämerei kontrastiert auf verblüffende Weise mit der zunehmenden Transparenz unserer sämtlichen Lebensaspekte, die wir auf den Plattformen des Digitalen Kapitalismus teilen sollen. „Privacy ist theft“ lautet denn auch einer der Wahlsprüche in Dave Eggers futuristischem Roman Der Circle.

„While powerful businesses, financial institutions, and government agencies hide their actions, our own lives are increasingly open books”. (Frank Pasquale)

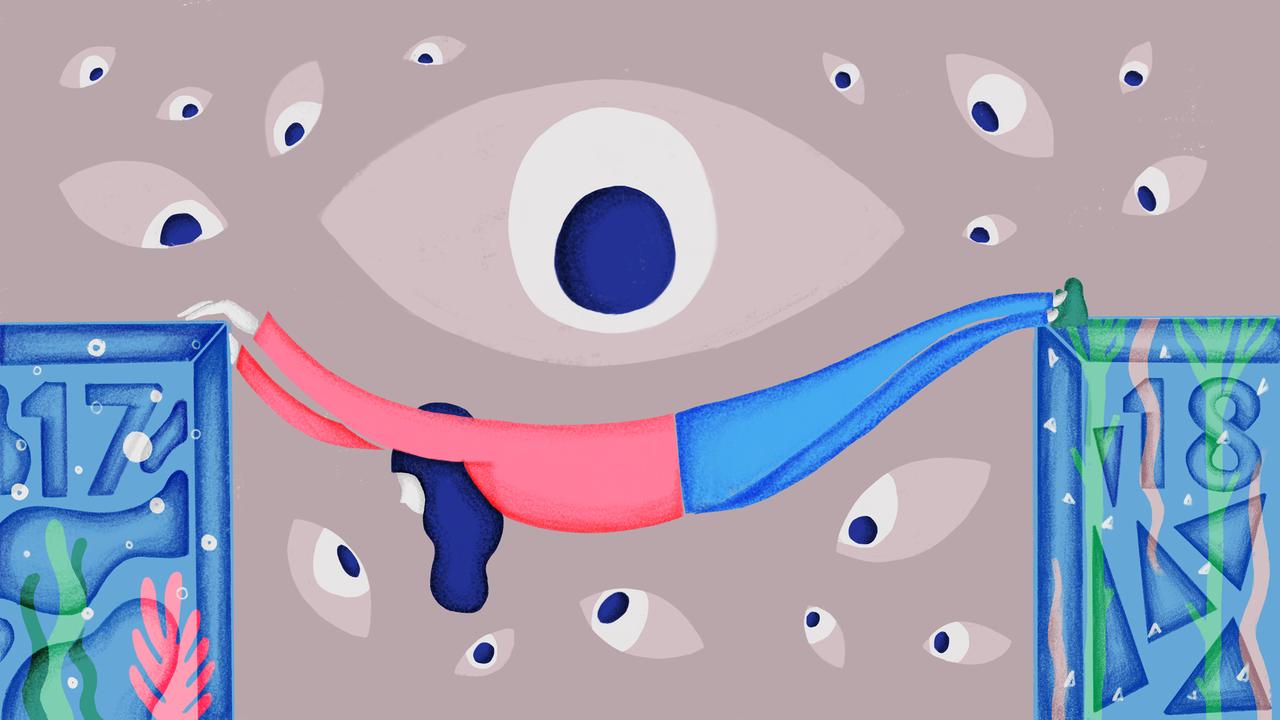

Algorithmen sollten rechenschaftspflichtig sein. Heißt: Es muss klar sein, wer oder was für ihre Entscheidungen haftet. Sie sollten transparent, ihre Entscheidungen sollten nachvollziehbar sein, es sollte verantwortliche Ansprechpartner geben. Datenschutzrechte wie Einsicht in die Daten und Entscheidungen, sowie Einklagbarkeit sollten gewährleistet sein. Auf EU-Ebene wird im Mai 2018 eine novellierte Datenschutzrichtlinie (General Data Protection Regulation, GDPR) in Kraft treten, mit der das Europäische Parlament, der Rat der Europäischen Union und die Europäische Kommission den Datenschutz für alle Personen innerhalb der EU stärken und vereinheitlichen wollen. Die Verordnung sieht unter anderem erstmalig vor, dass Entscheidungen von Algorithmen transparent und nachvollziehbar gemacht werden.

Quellen und Links

- Stephen D Krashen, Explorations in language acquisition and use, 2003.

- Frank Pasquale, The Black Box Society. The Secret Algorithms That Control Money and Finance, 2015.

- Frank Pasquale, How to hold Algorithms Accountable

- Hannah Devlin, AI programs exhibit racial and gender biases, research reveals, The Guardian, 13. April 2017.

- Will Knight, Forget Killer Robots—Bias Is the Real AI Danger, MIT Technology Review, 3.10.2017.